Blog

- Portada

- Creación Web

- Cursos

- Noticias

- Joomla!

- Ayuda para Joomla!

- Seguridad y Optimización Joomla!

- Vídeos Joomla!

- Eventos Joomla!

- Información

- Blog

- Descargas

- Ayuda

- N&S

En la categoría de: Artículos Generales

Palabras Clave: artículo, virus, troyano, caballo de troya, troya, malicioso, maligno, backdoor, firewall, cortafuegos, antivirus, puerta trasera, articulo

Publicado: 18-11-2010 (02:00)

Un troyano es un programa malicioso enmascarado como si fuera un programa legal y/o inofensivo. Al instalarlo creyendo su inocuidad es cuando se activa y despliega todo su potencial malintencionado.

Los troyanos se llaman también caballos de Troya, Trojan horse, o virus troyanos (aunque esta última no es del todo adecuada ya que no es un virus).

Una vez instalado, generalmente su actuación se basa en abrir puertas traseras (backdoor) para controlar el sistema de forma remota (esto es, a distancia) y poder conseguir información valiosa (cuentas bancarias, claves, etc.), e incluso pueden llegar a eliminar archivos, cerrar programas, utilizar la máquina para realizar spam, instalar programas de escucha, instalar virus, etc.

Otros troyanos sin embargo se activan sólo para molestar: agregan iconos sin sentido, cambian el escritorio, etc.

Por esto último, muchos afirman que es menos peligroso que un virus, pero la verdad es que esto depende mucho de la persona, de los datos que guarde y del tipo de troyano. El virus puede destruir la información, pero en ocasiones es preferible (si se tiene una copia de seguridad) a que cierta información caiga en manos ajenas.

Pues la diferencia es que el troyano no se propaga por sí mismo, si no que es el propio usuario quién lo activa y propaga al instalar un programa.

La palabra troyano o caballo de troya viene de la Odisea de Homero, donde relata como unos soldados vencieron a su enemigo ofreciéndole un enorme caballo para la ofrenta a los dioses. Una vez que propios aceptaron el caballo donde iban escondidos los mejores soldados, éstos salieron y los derrotaron.

Fotografía: Caballo utilizado en la película Troya de 2004.

El caballo de Troya informático es muy similar al que relata Homero, es un código malicioso escondido en un programa lícito, y que actúa una vez instalas el programa.

Las formas más usuales para contraer un troyano son:

Para evitar infecciones con troyanos hay que tener en cuenta lo siguiente:

Un proxy (proxies en plural, ya que es una palabra inglesa) es un ordenador intermedio que se usa en la comunicación de otros dos. La información (generalmente en Internet) va directamente entre un ordenador y otro. Mediante un proxy, la información va, primero, al ordenador intermedio (proxy), y éste se lo envía al ordenador de destino, de manera que no existe conexión directa entre el primero y el último.

El objetivo de esto, entre otros, es enmascarar la procedencia de la petición, es decir, que el servidor que envía la información sabe que la envía a un ordenador (proxy), pero no sabe el destinatario final al que va dirigido.

En casi la totalidad de los casos, el proxy sólo sirve para ocultarse, y la mayoría de las veces estos proxies se usan para realizar prácticas ilegales (spam, fraudes, etc.). Es por ello, por lo que siempre es deseable evitar los proxies, sobre todo cuando son servidores de foros, chat o redes sociales.

En otros casos (esa minoría de los casos), es cuando se usa un proxy como interconexión entre muchos ordenadores de una red, con Internet. En ese caso, se puede usar un proxy por las ventajas añadidas que posee.

La única manera de que tu servidor no sirva información a proxies es baneando (prohibiendo el acceso) a estos proxies que suelen tener una IP (número asignado a una máquina en Internet).

Los webmasters tienen la capacidad de realizar el baneo de una IP de forma relativamente sencilla. Pero el problema radica en que los proxies se crean y se destruyen tan rápido que son muy difíciles de controlar.

Básicamente existen porque la gente gana dinero con ellos. Todos los proxies en su web tienen publicidad que les genera dinero. Como además no tiene porqué usarse para prácticas ilegales, no existe una barrera para prohibirlos. Tampoco creemos que deba prohibirse porque, por supuesto, existen excepciones lícitas.

Pues con una IP dinámica, un servidor, un dominio, configurar el servidor (Linux o Windows) para ello, una sencilla página web, banners de publicidad y promocionarse (anunciarse). No vamos a dar más datos de cómo se monta, ni dónde conseguir la información ya que ese no es nuestro cometido con este artículo, sino sólo saber qué son y para qué se usan.

Cuando se usa un proxy en una red interna para usarlo como conexión entre el exterior (Internet) y el interior (cada ordenador interno) posee muchas ventajas:

En otros casos la mayor ventaja, sin duda, es:

Someramente, existen:

En la categoría de: Artículos sobre Páginas Web

Palabras Clave: artículo, archivo, archive, alexa, dmoz, ver, website, obsoleto, antigua, internet archive, wayback machine, hardware, wayback, recuperar, historia

Publicado: 10-11-2010 (22:54)

Tanto si buscas información que ya no existe, quieres recuperar viejos escritos, o incluso quieres saber qué ha pasado con ese enlace en Favoritos (Bookmarks) que ahora no encuentras, esta es la web que buscas.

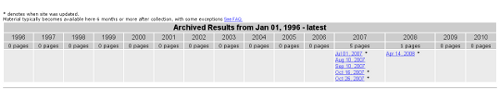

En su web hay una casilla para introducir la dirección del sitio que quieres ver. Al pinchar en buscar aparecerá una web similar a ésta:

donde expone las fechas de las cuales tiene copia de esa web. Sólo debes pinchar en cualquier fecha que te interesa y te mostrará la web como estaba en aquel momento.

El principal inconveniente es que esta web archiva correctamente el contenido pero no las hojas de estilo, que al fin y al cabo son las que dan forma a una web. Por lo tanto, la web puede quedar algo desorganizada y con falta de color.

Otro inconveniente es que muchos archivos, sobre todo gráficos, no son guardados, por lo que pueden faltar ciertos contenidos.

El texto y muchos gráficos, que en la mayoría de los casos, es lo que suele importar, siempre está accesible, incluso a niveles de la web ciertamente profundos.

Otra ventaja es la disponibilidad de varias fechas para una misma web, que hace que los contenidos dinámicos (aquellos que cambian a lo largo del tiempo) puedan ser recuperados.

Todas las páginas que estén dadas de alta en Dmoz o sigan las instrucciones de alta de Alexa, están indexadas en Internet Archive, siempre teniendo en cuenta que han sido indexadas desde 1996. También están indexadas todas las webs que se visitan desde un navegador que tenga instalada la barra de navegación de Alexa.

Pero existe un caso en el que la web no será indexada, y es que su autor no quiera que se indexe. Esto se puede llevar a cabo mediante la limitación de los robots que inspeccionan la web, y que cualquier webmaster sabe como controlar en el fichero de acceso de la web o el creado exclusivamente para los robots; o mediante email dirigido a archive.org.

Las webs se rastrean unos 2 meses después de la creación de la web, siempre que se cumplan los requisitos anteriormente explicados, aunque no son puestos en la Wayback Machine hasta los 6 meses desde el rastreo, pudiéndose prorrogar hasta los 2 años posteriores. Tampoco tienen porqué respetar estos plazos, pueden ser mucho más cortos, o incluso pueden llegar a ser muy breves para una web y muy largos para la misma web pero en otra fecha.

La mejor manera de ver todos los ficheros archivados del sitio es poniendo en el navegador la dirección

Tenga en cuenta de nuevo que siempre existe entre 6 y 14 meses de media de tiempo de retraso entre la fecha de un sitio que se rastrea y la fecha que aparece en la Wayback Machine.

En la categoría de: Artículos sobre Páginas Web

Palabras Clave: artículo, spider, robot, bot, araña, rastreador, webcrawler, crawler, googlebot, yahoo slurp, slurp, google, bing, msnbot, que es, para qué sirve, para que sorve, php, indexar, spambot

Publicado: 24-09-2010 (23:12)

Un robot de Internet es un programa de ordenador que rastrea una web y analiza y capta los datos de la página web para algún fin particular. Otros nombres por los que se conocen a los robots son: spider, araña (por la traducción de la palabra spider), bot (de la palabra robot), crawler (rastreador en español), webcrawler, etc.

Los robots se suelen utilizar para:

1.- Crear un índice para un buscador. Lo suelen usar los buscadores de Internet (Google, Yahoo, Bing, etc.)

2.- Para indexar un sitio en internet. Esto lo suelen usar los directorios de Internet.

3.- Analizar un sitio web para determinar carencias (links rotos, fallos de código, etc.). Lo suelen utilizar cualquier persona con interés para ello o sitios de certificados de normas tipo el consorcio W3C.

4.- Recolectar información para hacer un registro de datos (tipo precios de una página web, tipo de productos de una web, etc.). Esto lo suelen usar los propios webmaster para recopilar información o metapáginas (páginas que recopilan información de otras páginas).

5.- Recolectar información ilícita. Lo usan los cuerpos de seguridad del estado para encontrar páginas ilícitas o con contenido ilegal.

Los bots no dejan de ser un programa de ordenador que actúa de forma automática. Para ello hay que programarlo en cualquier lenguaje adecuado a sus pretensiones. Lo más normal es usar PHP o PERL.

En Net&Software ya hemos creado unos cuantos bots para poder realizar una recolección de información sobre productos de un proveedor del cliente, de manera que el cliente pudiera usar esta información del proveedor para realizar su base de datos propia con estos datos. Nosotros siempre hemos usado PHP para realizarlos.

Aunque hay tantos rastreadores (crawlers) como programadores que quieran hacer uno, los más importantes son:

| Nombre del robot | Propietario |

| Googlebot | |

| Feedfetcher-Google | |

| Slurp | AOL |

| MSNBot | Microsoft |

| Yahoo Slurp | Yahoo |

| IA Archiver | Archive.org (Wayback Machine) |

| Scooter | Altavista |

| Architext Spider | Excite |

| Lycos | Lycos |

| Netcraft | Netcraft |

Googlebot es el robot de rastreo web de Google, y quizás uno de los más importantes en la actualidad. Es por ello que se merece una mención especial. Mediante este robot Google descubre las páginas nuevas y las actualizaciones de las que ya tiene indexadas de manera que su buscador siempre se mantiene actualizado.

Es importante para los webmasters explicarle al robot de Google con qué asiduidad se actualizan los contenidos de una web y la importancia que tienen las páginas que el robot encuentra. De esta forma GoogleBot rastrea el sitio de forma eficiente. Para ello se usan los sitemap (mapas del sitio), archivos ocultos a la vista de los usuarios pero muy útiles para el robot de Google y, en general, para los demás robots. Además se utiliza el fichero robots.txt para explicarle a los robots qué deben visitar y qué no.

En ocasiones es importante explicar a los robots que no deben seguir los vínculos. Los webmasters tenemos herramientas para hacer esto. Se trata de poner un código oculto a la vista de los usuarios en la página que no queramos que vincule:

<meta name="Googlebot" content="nofollow">

Aunque GoogleBot u otros robots hayan rastreado su web, éstos no aparecen de forma inmediata en el buscador de Google, o incluso pueden no aparecer. Esto último se produce por duplicación de contenidos de otras páginas de la web.

Los spambots son robot creados para rastrear páginas web para captar email, teléfonos, e información personal. Con ello recopilan una base de datos que pueden vender a terceros o realizar Spam para mandar publicidad no deseada.

Por esta razón no se recomienda hacer público tu email en foros o páginas web. En caso de ser necesario se puede optar por hacerlo de otra forma, de manera que a los spambots les cueste trabajo reconocer que lo que están leyendo es un email: meter espacios en blanco, escribir ARROBA en vez de @, incluso publicar tu email en forma de fichero gráfico. Aunque no sea del todo infalible son una buena medida.

Explicaciones sencillas a cualquier término informático de Internet o Joomla!.

Está disponible para descargar Joomla! 3.5.0. Es una versión muy esperada, que implementa muchas mejoras de funcionalidad. Entre las...

Está disponible para descargar Joomla! 3.4.4. Es una versión de seguridad que repara pequeños errores de seguridad, por lo que se...

Ya se está preparando la nueva versión de Joomla!, la 3.4.4. Por el momento está en la versión RC -Release Candidate- y aunque se puede...

Aunque puede parecer una pregunta complicada, no lo es tanto. Se debe principalmente a los cambios de estrategia del proyecto que se produjo...

Introducción Joomla! es un sistema creado en el lenguaje de programación orientado a objetos PHP, que usa el servidor de bases de datos...

Introducción Los profesionales de la creación web nos encontramos con infinidad de situaciones en la que personas interesadas en tener su propia...

Web 2.0. Desarrollo Joomla! y Programación Web. Cursos Online Videoconferencia, Amplia Experiencia en Joomla!, Posicionamiento Orgánico SEO.